|

"Тогда как задать возбуждение рецепторов, если инспектор точно установил, что скорость автомобиля при наезде на пешехода была равна 114 км/час? Вопрос по расчёту скорости и сумме достоверности: этот математический (приведенный выше в виде контекста из материала лекции 1, страницы 3) метод справедлив к скоростным показателям выходящим за рамки диапазона 100-120. |

Развитие логической нейронной сети для распознавания объектов по заданному набору признаков

Нечеткие оценки признаков объектов временного ряда

Проходят годы, а Маша все сидит за самоваром у раскрытого окошка и слабеющими глазами пытается угадать свой идеал. Конечно, только с долей вероятности (достоверности) она может оценить значение каждого из интересующих ее признаков, в комплексе влияющих на ее настроение.

В этих условиях неопределенности мы спешим на помощь, вооруженные современными положениями теории нечетких множеств, призванными обосновать задание исходной информации на рецепторном слое Машиной нейронной сети.

Первоначально мы вынуждены признать, что каждое значение любого признака (не следует забывать, что эти значения соответствуют исчерпывающему множеству событий) определяется с достоверностью  . А куда девать остальные 1-Р?

. А куда девать остальные 1-Р?

Практический, "инженерный" подход заключается в рассмотрении нормального закона плотности распределения вероятностей. Согласно ему, все вероятности событий исчерпывающего множества, в сумме образующие единицу, распределены между "смежными" по смыслу и содержанию высказываниями, т.е. служат возбуждению соответствующих рецепторов так, чтобы измеренное или предполагаемое значение Р было близко к математическому ожиданию значения признака или совпадало с ним.

Продемонстрируем (рис.5.1) возбуждение рецепторов на основе нечетких оценок значений параметров.

Пусть, оглядывая очередного проходящего мужчину, Маша быстро прикидывает:

- Процентов на 70 я уверена, что он брюнет, хотя, возможно, он блондин или шатен. Ведь он, кажется, в шляпе;

- Его рост не менее 190 см, в этом я уверена процентов на 80;

- Носа я совершенно не вижу; возможно, он закрыт тенью от шляпы или шевелюры;

- Не пойму: шляпа у него или такая шевелюра? Скорее, все же, шляпа.

Не смея долго раздумывать (ведь из соседней закусочной показался следующий мужчина), Маша формирует возбуждение рецепторов:

По-видимому, формирование эвристического алгоритма такого "разбрасывания" вероятностей, на глазок воспроизводящего нормальный закон, не представляется трудным.

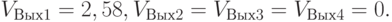

Для функции активации (5.1) в условиях допущенной неопределенности необходимо снизить значение порога h. Он должен подбираться экспериментально, чтобы Маша не лишилась окончательно удовольствия и надежды. Положим h = 2,5 и рассчитаем возбуждение нейронов выходного слоя:

Так что радости еще есть место.

В общем случае признаки объектов временного ряда преимущественно имеют действительные значения из широкого диапазона, являясь отражением измерений различных физических, динамических, временных и прочих характеристик. Разбивка этого диапазона на большое количество малых интервалов значений – для закрепления за ними рецепторов – позволяет более точно воспроизводить нормальный закон распределения вероятностей. Это соответствует условному воспроизведению гистограммы.

Введение обратных связей

Весьма высокая скорость обработки потока объектов временного ряда, исключающая возможность сопутствующих размышлений и переживаний, наводит Машу на справедливую мысль. В очередной раз, встретив свой идеал, следует некоторое время предаваться кайфу (специальной обработке искомого объекта временного ряда вне общего режима анализа потока), а не пялить глаза на всех подряд проходящих мужчин.

Для этого необходимо использовать обратные связи, - с целью выработки некоторого тайм-аута, позволяющего осмыслить и благотворно пережить важное событие – встречу с вожделенным объектом, несмотря на продолжающую изменяться ситуацию.

Замедлить и растянуть встречу, то есть отвлечься на анализ и обработку интересующего объекта временного ряда, можно с помощью продолжительной поддержки возбуждения рецепторов, определивших появление информации об объекте. Это позволит на некоторое время запомнить образ, подержать его в памяти – навевающего сладкие мечты.

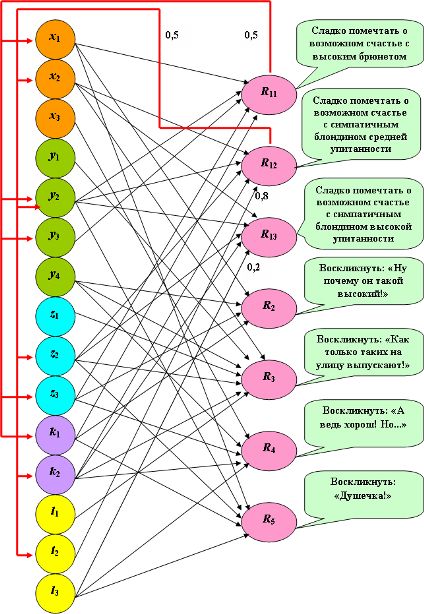

Значит, необходимо сформировать положительные обратные связи (рис.5.6ведущие от каждого нейрона выходного слоя, соответствующего решению по объекту с интересующими (идеальными) признаками, к тем нейронам-рецепторам, которые вызывают его столь высокое возбуждение. Тогда это возбуждение будет поддерживать высокое возбуждение соответствующих рецепторов, а они, в свою очередь, будут поддерживать высокое возбуждение нейрона выходного слоя.

Поскольку на рецепторы в результате обратных связей следует подавать приведенные значения возбуждения, интерпретируемые как поправки к достоверности, то следует использовать функцию активации (5.4).

Однако этот процесс поддержки высокого возбуждения нейрона выходного слоя должен быть затухающим. Ведь повздыхав, Маше ничего не остается делать, как продолжать свои "исследования". Это затухание достигается с помощью значений весов обратных связей, меньших единице. На рис.5.5 такие веса обратных связей приняты равными 0,5. (Комментировать решение  с помощью обратных связей Маша отказывается.) Спустя некоторое время СПР вернется к регулярному режиму обработки объектов временного ряда.

с помощью обратных связей Маша отказывается.) Спустя некоторое время СПР вернется к регулярному режиму обработки объектов временного ряда.

Параллельная обработка сигналов, поступивших на рецепторный слой, является непременным условием высокой скорости ассоциативного мышления, свойственного мозгу. Обработка объектов (информационных кадров, состояния средств испытываемых сложных систем, потактового формирования управляющих воздействий и т.д.), образующих временной ряд, методами ассоциативной селекции позволяют приблизить эту обработку к режиму реального времени.

Ключевые термины

SPMD-технология (Single Program – Multiple Data) – одновременная работа многих процессоров (компьютеров), выполняющих копии одной программы по распределенным данным. Технология в максимальной степени адекватна распределенной обработке нейронов на параллельном нейрокомпьютере.

Структурированная логическая нейронная сеть – характеризуется скобочной структурой логического описания системы принятия решений.

Длина конъюнкции - количество переменных, объединенных операцией И.

Краткие итоги

- Логические нейронные сети являются важным аппаратом параллельного выполнения сложных логических конструкций. В то же время, только разработка нейрокомпьютеров – параллельных вычислительных систем, специализированных для параллельного счета значений несложных функций активации нейронов сети, подобно тому, как это делается в мозге, позволяет практически решать проблему оперативной обработки временных рядов.

- Применение логических нейронных сетей значительно снижает трудоемкость распознавания объектов, следующих в потоке реального времени.

- Это снижение трудоемкости обусловлено двумя факторами: а) применением простейшей функции активации нейронов, б) возможностью параллельной и распределенной обработки большого количества нейронов.

- Однослойные логические нейронные сети значительно упрощают обработку, устраняют неоднозначность решений, облегчают модификацию и развитие.

- Обратные связи позволяют оперативно и временно изменять алгоритм действия пользователя, расширять возможности его действий в случае возникновения некоторых ситуаций.

Вопросы:

- Как на основе оценок признаков объектов временного ряда производится логическое описание системы распознавания?

- Как строится логическая нейронная сеть для обработки нечетких данных?

- Как строится матрица следования для однослойной логической нейронной сети?

- Почему попытка "механического" объединения ситуаций в рамках однослойной логической нейронной сети способна привести к некорректности ее решений?

- Как производится развитие однослойной логической нейронной сети?

- Как выбирается функция активации нейрона, если все или некоторые веса связей меньше единицы?

- Для чего и как вводятся обратные связи?